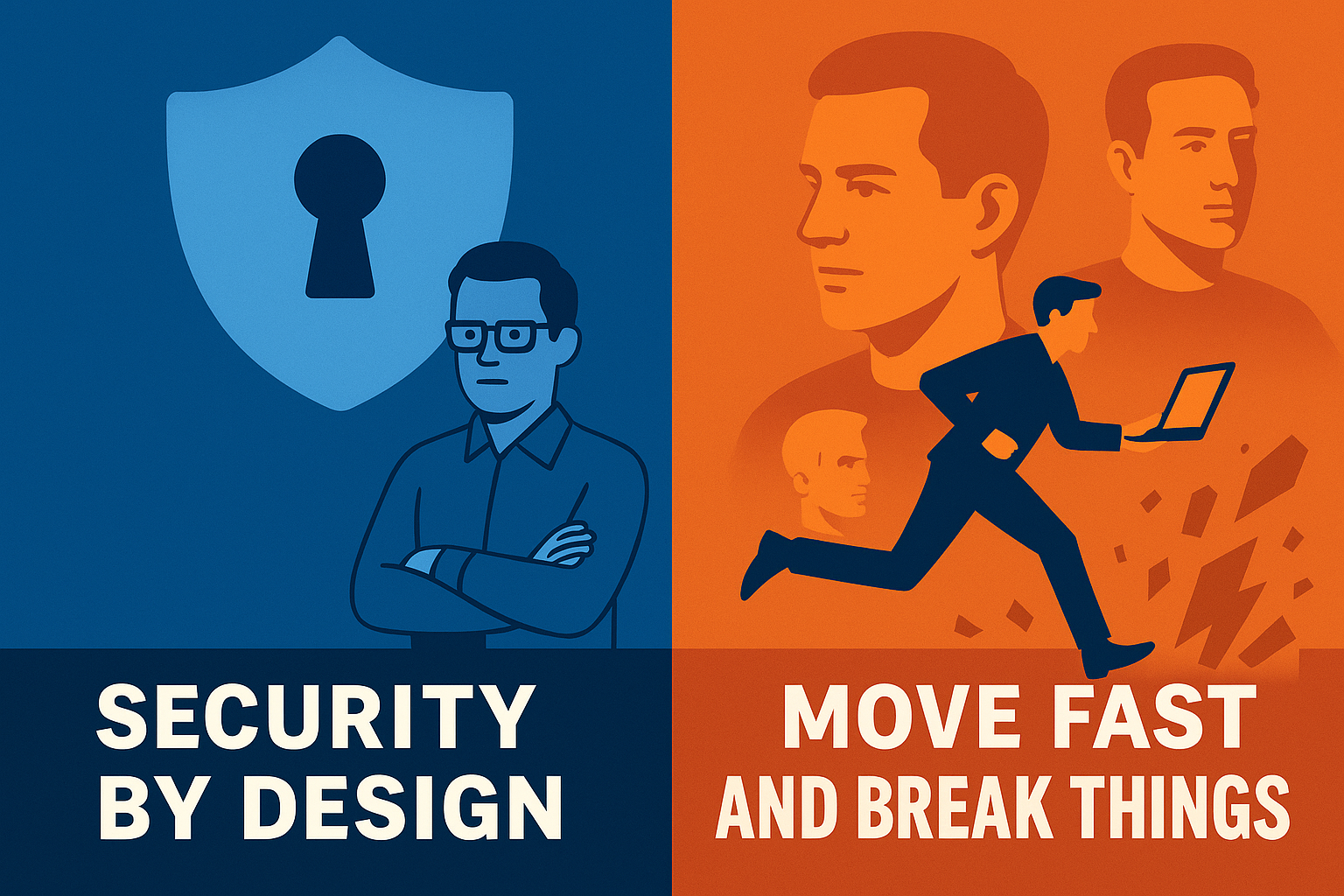

In der Softwareentwicklung prallen zwei gegensätzliche Haltungen aufeinander. Auf der einen Seite steht Security by Design, ein Ansatz nach dem Vorsorgeprinzip: Software soll von Anfang an sicher und vorausschauend entwickelt werden, um Schaden präventiv zu verhindern. Auf der anderen Seite steht der radikale Innovationsdrang, oft verkörpert durch das Motto „Move Fast and Break Things“. Dieser agnostische Experimentalismus fördert schnelle Iteration und nimmt Risiken bewusst in Kauf – Fehler und Sicherheitslücken werden dabei zunächst toleriert, in der Annahme, sie später beheben zu können.

Diese Gegenüberstellung wirft eine zentrale Ethik-Frage auf: Wie viel Vorsicht verträgt die Innovation, und wie viel Risiko ist verantwortbar? Welcher Ansatz ist gesellschaftlich verantwortbar? Entwickler tragen eine Verantwortung gegenüber den Nutzern und der Gesellschaft. Dieser Artikel beleuchtet diese Verantwortung aus philosophischer Sicht. Mit Blick auf Folgenverantwortung – etwa Hans Jonas’ Prinzip Verantwortung (vgl. https://de.wikipedia.org/wiki/Das_Prinzip_Verantwortung) – wird diskutiert, wie Entwickler die langfristigen Folgen ihrer Innovationen bedenken müssen. Zudem wird erörtert, warum “Ethik by Design” an Bedeutung gewinnt. Beispiele wie unsichere IoT-Geräte (Internet of Things) mit Sicherheitslücken zeigen die greifbaren Folgen unverantwortlicher Innovation und illustrieren, weshalb ein Umdenken notwendig ist.

Security by Design: Vorsorgeprinzip in der Technik

Security by Design verkörpert das Vorsorgeprinzip in der Softwareentwicklung. Dieser Ansatz fordert, Sicherheit von Anfang an mitzudenken, statt sie erst im Nachhinein einzubauen. Ähnlich wie im Umweltschutz das Vorsorgeprinzip besagt “Drohen große Schäden, ist Vorsorge ratsam”[1], soll auch in der IT vorbeugend gehandelt werden. Anstatt nur auf bekannte Risiken zu reagieren, plant man antizipativ: Potenzielle Schwachstellen werden schon im Design vermieden, bevor überhaupt ein Schaden entstehen kann. Im Datenschutz und beinahe der gesamten Cybersecurity-Regulatorik ist dieser Ansatz ohnehin maßgeblich.

Philosophisch betrachtet geht Security by Design damit konform mit einer Ethik der Verantwortung und der Klugheit. Es folgt der Einsicht, dass Technikfolgen oft unsicher und weitreichend sind. Das Vorsorgeprinzip erlaubt in seiner starken Form sogar, Freiheiten einzuschränken, um Schaden abzuwenden, selbst wenn die Gefahren noch nicht voll bewiesen sind[1]. Übertragen auf Software heißt das: Entwickler verzichten im Zweifel auf bestimmte riskante Features oder nehmen Mehraufwand in Kauf, um sicherzustellen, dass ihre Anwendung keine unverantwortbaren Risiken birgt.

Beispiel: Bei sicherheitskritischen Anwendungen (etwa in der Medizintechnik oder im autonomen Fahren) ist Security by Design unverzichtbar. Hier muss schon im Architekturkonzept die mögliche schlimmste Folge eines Softwarefehlers (Verletzungen, Todesfälle) mitbedacht werden. Das Vorsorgeprinzip würde argumentieren: Auch ohne absolute Gewissheit über alle Risiken darf man Sicherheit nicht dem Zufall überlassen. Lieber am Anfang etwas langsamer und sorgfältiger entwickeln, als später großes Leid verantworten zu müssen.

Aus praktischer Sicht bedeutet Security by Design etwa, dass Sicherheits-Maßnahmen in jedem Schritt des Software-Lebenszyklus eingebaut werden: Threat Modeling in der Architekturphase, sichere Coding-Guidelines in der Implementierung, rigorose Tests auf Schwachstellen, etc. Der Gewinn ist eine robuste Software, die weniger anfällig für Angriffe ist – das beugt Datenlecks, Systemausfällen und Missbrauch vor. Studien zeigen, dass ein solches Vorgehen langfristig sogar Kosten spart, weil teure nachträgliche Patches und Schadensbehebungen reduziert werden[2].

Doch Security by Design hat auch eine Kehrseite: Es kann die Entwicklungsgeschwindigkeit bremsen. Zusätzliche Sicherheitsprozesse kosten Zeit und Ressourcen. Hier entsteht der Konflikt mit der gegenläufigen Philosophie, dem schnellen Innovationsdrang.

“Move Fast and Break Things”: Risiko und Innovationsdrang

Der Leitspruch “Move Fast and Break Things” entstammt der Startup-Welt (berühmt geworden durch Facebooks frühe Tage) und steht sinnbildlich für eine Kultur des Experimentierens ohne Angst vorm Scheitern. Diese Haltung priorisiert schnelle Innovationszyklen über Stabilität: Lieber rasch neue Features herausbringen – und in Kauf nehmen, dass dabei auch mal etwas kaputt geht – als langsam und fehlerfrei zu arbeiten. Der Gedanke dahinter: Aus Fehlern lernt man; was kaputtgeht, wird eben schnell geflickt. Dieser Ansatz hat die Tech-Branche in den vergangenen Jahrzehnten geprägt und zweifellos viel Kreativität freigesetzt.

Aus ethischer Sicht wirft “Move Fast and Break Things” allerdings Fragen auf. Was wird da eigentlich “gebrochen”, und wer trägt die Konsequenzen? In der Softwareentwicklung sind es oft die Nutzer und die Gesellschaft, die die Risiken mittragen: Sicherheitslücken in schnell entwickelter Software können zu Datenschutzverletzungen führen, zu finanziellen Schäden oder gar Gefährdungen von Menschenleben in kritischen Systemen. Die Maxime der schnellen Innovation steht damit im Widerspruch zur Sorgfaltspflicht. Ein Facebook-ähnliches soziales Netzwerk mag es sich leisten können, dass hin und wieder ein Feature nicht funktioniert – bei einer Banking-App oder einer Verkehrssteuerungssoftware kann “Break Things” fatal sein.

Tatsächlich hat sich gezeigt, dass diese Mentalität ohne ausreichende Korrektive ernsthafte Folgen haben kann. Inherently at odds with writing secure software – so beschreiben Experten die Konfliktlage: Das “schnell etwas rauswerfen” verträgt sich schlecht mit durchdachter Sicherheit[2]. Nachlässigkeit bei der Code-Sicherheit hat oft schwere Konsequenzen: Datenlecks, Verletzung der Privatsphäre von Nutzern, finanzielle Verluste und Reputationsschäden für Unternehmen sind dokumentierte Folgen unsauber entwickelter Software[2].

Ein markantes Beispiel für die Risiken eines ungebremsten Innovationsdrangs ist die IoT-Branche. Viele IoT-Geräte (von Überwachungskameras bis Smart Lightbulbs) kamen in den letzten Jahren hastig auf den Markt – oft ohne grundlegende Sicherheitsvorkehrungen. Die Devise war offenbar, schnell Marktanteile zu gewinnen und sich einen Namen zu machen, während Security-Features hintenan standen. Das Ergebnis: Zig Produkte mit Standard-Passwörtern, fehlenden Updates und offenen Schnittstellen. Diese Schwachstellen wurden zum Bumerang. 2016 etwa nutzten Hacker zahllose unsichere IoT-Geräte (insbesondere Kameras und Router) und infizierten sie mit der Malware Mirai. Im Oktober 2016 formte Mirai so ein Botnetz aus zehntausenden gekaperten Geräten und startete einen gewaltigen DDoS-Angriff, der weite Teile des Internets in den USA lahmlegte[3]. Diese Episode – ein “Bruch” im wörtlichen Sinne – zeigte eindrücklich, dass ungezügelte Innovationsfreude ohne Mindestmaß an Vorsicht extreme Schäden verursachen kann.

Zusammengefasst: Move fast and break things fördert zwar Agilität und Fortschrittstempo, setzt aber die gemeinschaftliche Verantwortung herab. Im besten Fall führt das zu kleinen Bugs, im schlimmsten Fall zu systemischen Risiken. Die Haltung, Risiken “in Kauf zu nehmen”, stellt sich moralisch die Frage: Wer gibtdas Recht, die Sicherheit anderer zu gefährden, nur um schneller zu innovieren? Genau hier müssen wir über Verantwortung sprechen.

Verantwortung der Entwickler gegenüber der Gesellschaft

Softwareentwickler gestalten mit ihrer Arbeit die digitale Welt, in der wir leben. Daraus erwächst eine Verantwortung gegenüber der Gesellschaft. Jede neue Technologie kann neben Nutzen auch Schaden bringen – und Entwickler stehen ethisch in der Pflicht, diese möglichen Folgen abzuwägen. Der Philosoph Hans Jonas mahnte bereits 1979 in “Das Prinzip Verantwortung” vor den unbedachten Folgen technologischen Handelns. Seine Verantwortungsethik betont die Pflicht des Menschen, verantwortungsvoll mit der Umwelt und den zukünftigen Generationen umzugehen[3]. Übertragen auf die Softwareentwicklung heißt das: Entwickler sollen die längerfristigen Auswirkungen ihrer Innovationen bedenken, nicht nur den kurzfristigen Erfolg.

Jonas formulierte sinngemäß einen neuen kategorischen Imperativ für das technische Zeitalter: Handle so, dass die Wirkungen deiner Handlungen verträglich sind mit der Permanenz echten menschlichen Lebens auf Erden. In unserem Kontext könnte man abwandeln: Handle so, dass deine Software die Sicherheit und Würde jetziger und künftiger Nutzer wahrt. Diese Prämisse fordert eine Folgenabschätzung schon bei der Ideenfindung: Was passiert, wenn mein Produkt millionenfach eingesetzt wird? Welche Missbrauchspotentiale gibt es? Könnten Unbeteiligte zu Schaden kommen?

Konsequenz-Verantwortung bedeutet, man übernimmt moralisch Verantwortung nicht nur für das, was man beabsichtigt hat, sondern auch für das, was daraus resultiert. Ein Entwickler mag zum Beispiel ein Feature in guter Absicht programmieren, doch wenn es eine Sicherheitslücke hat, die dann für Datendiebstahl genutzt wird, steht die Frage im Raum: Hätte er das vorhersehen und verhindern müssen? Die Verantwortbarkeit von Innovation bemisst sich daran, ob die Risiken in einem vertretbaren Verhältnis zum Nutzen stehen und ob die Akteure alles Zumutbare getan haben, um diese Risiken zu minimieren.

Gerade in einer vernetzten Gesellschaft haben Softwarefehler oft eine weite Reichweite. Ein einzelnes skrupelloses Startup, das schnell etwas Unsicheres auf den Markt wirft, kann das Vertrauen in ganze Technologien erschüttern. Umgekehrt kann ein verantwortungsvoller Entwickler durch Weitsicht und Vorsorge großen Schaden vom Ökosystem abwenden.

Die Verantwortung gegenüber der Gesellschaft manifestiert sich auch in Konzepten wie Open-Source-Sicherheit, Transparenz und Accountability. Wenn Fehler passieren, erwartet die Gesellschaft zu Recht, dass Firmen und Entwickler dazu stehen, umgehend handeln und aus ihnen lernen. Ethik in der Technik verlangt also nicht Fehlerlosigkeit (das wäre utopisch), sondern den aufrichtigen Willen, Schaden von anderen abzuhalten und im Zweifel die Notbremse zu ziehen, bevor man ein riskantes Produkt verantwortungslos verbreitet.

Ethik by Design: Wenn Technik moralische Werte integriert

Analog zum Begriff „Security by Design“ hat sich der umfassendere Ansatz “Ethik by Design” herausgebildet. Dahinter steckt die Idee, dass nicht nur Sicherheitsaspekte, sondern auch allgemeine ethische Werte von Anfang an in die Gestaltung von Technologien einfließen sollen. In einer Zeit, in der Softwareentscheidungen soziale Prozesse und persönliche Schicksale beeinflussen (man denke an KI-Algorithmen, Social Media, autonome Systeme), wird klar: Entwickler gestalten nicht nur Code, sie gestalten Lebensrealitäten mit.

Ethik by Design fordert, schon in der Konzeptionsphase Fragen zu stellen wie:

- Dient das Produkt dem Wohl der Nutzer und ggf. der Allgemeinheit?

- Welche möglichen negativen Auswirkungen (Missbrauch, Abhängigkeit, Diskriminierung, Sicherheitsrisiken) birgt es und wie können wir diese proaktiv verringern?

- Werden Werte wie Privatsphäre, Autonomie, Gerechtigkeit und Sicherheit respektiert?

Dieser Ansatz gewinnt an Bedeutung, weil er eine Antwort auf konkrete Probleme der Tech-Branche ist. Allzu oft wurde in der Vergangenheit zuerst innoviert und hinterher über Ethik nachgedacht – man nennt dies auch einen reaktiven Ansatz. Immer wieder zeigte sich jedoch, dass diese Reihenfolge mangelhaft ist. Ein Beispiel: Soziale Netzwerke führten Neuerungen ein (etwa Gesichtserkennung in Fotos), ohne Datenschutzbedenken vorab ernsthaft durchzuspielen. Das Ergebnis waren öffentliche Aufschreie und Vertrauensverluste, die man mit antizipativer Ethik vielleicht vermieden hätte.

Bei IoT-Geräten ist Ethik by Design praktisch deckungsgleich mit Security by Design. Die Ethik gebietet hier, die Nutzer nicht durch Unsicherheit zu gefährden. Der Fall der Mirai-Malware demonstrierte, dass Hersteller, die keine hinreichenden Sicherheitsvorkehrungen eingebaut hatten, indirekt an einem massiven Internet-Ausfall mitverantwortlich wurden[3]. Hätten alle Hersteller von Anfang an z.B. eindeutige individuelle Passwörter und Update-Mechanismen vorgesehen (security by default), wäre dieses Botnet kaum möglich gewesen. Ethik by Design würde also z.B. lauten: Baue nur IoT-Geräte, die grundlegende Sicherheitsstandards erfüllen, um die Allgemeinheit nicht zu gefährden. Genauso gilt: Entwickle KI-Systeme so, dass sie keine unfairen Vorurteile verstärken, etc.

Interessant ist, dass Ethik und Innovation sich nicht ausschließen, sondern langfristig sogar gegenseitig fördern. Wenn Nutzer darauf vertrauen können, dass Produkte gewissenhaft entwickelt wurden, steigt die Akzeptanz neuer Technologien. Umgekehrt führen ethische Skandale (Datenlecks, Missbrauch von Facebook-Daten, unsichere Produkte) zu Regulierungen und Misstrauen, was die Innovationsfreiheit einschränkt. Es liegt also auch im Eigeninteresse der Tech-Industrie, Ethik by Design zu verfolgen. Wie ein aktueller IoT-Ethik-Bericht hervorhebt: Ignorieren der ethischen Implikationen könnte erheblichen gesellschaftlichen Schaden anrichten und das volle Potenzial der Technologie behindern[4]. Security by Design ist dabei ein Kernbestandteil: Genauso wie Privacy by Design verlangt, Datenschutz von Anfang an mitzudenken, verlangt Security/Ethik by Design, die Produktsicherheit als integralen Bestandteil der Innovation zu betrachten. Branchenexperten betonen: “Security by design is as important as privacy by design” – robuste Schutzmaßnahmen müssen über den gesamten Entwicklungsprozess hinweg implementiert sein[4]. Das ist letztlich nichts anderes als angewandte Ethik.

Wandel der Entwicklungskultur

Die zunehmende Betonung von Ethik by Design spiegelt sich auch in einem Kulturwandel in der Softwareindustrie wider. Firmen ersetzen oder ergänzen das Motto „Move Fast and Break Things“ durch Leitsätze wie „Move Fast and Build Things (without breaking them)“ oder „Do the Right Thing“. Sicherheits- und Ethik-Teams werden früh in Projekte eingebunden, und es entstehen neue Rollen wie „Ethik-Ingenieur“. Auch Frameworks und Normen (z.B. Ethik-Leitlinien für KI, ISO-Standards für IT-Security) geben Entwicklern Orientierung, wie sie ihre Verantwortung praktisch umsetzen können.

Fazit: Die Verantwortbarkeit von Innovation

Die philosophische Betrachtung zeigt: Innovation und Verantwortung dürfen kein Widerspruch sein. Verantwortbare Innovation bedeutet, Neues zu schaffen, ohne blind Risiken zu übergehen. Das Vorsorgeprinzip gibt hierbei die Richtung vor: Wenn große (mögliche) Schäden im Raum stehen, muss die Bremsbereitschaft vorhanden sein – kurz innehalten, Sicherheit einbauen, Experten konsultieren – bevor man weiter Gas gibt.

Security by Design verkörpert diese Verantwortung, indem es Sicherheit und Ethik als Grundkomponenten des Entwicklungsprozesses definiert. “Move Fast and Break Things” dagegen, in Reinkultur gelebt, verkennt die moralische Rechenschaftspflicht: Wer wissentlich Bruch in Kauf nimmt, muss auch die Verantwortung für die Bruchstücke tragen. In Bereichen, wo nur Sachwerte betroffen sind, mag das tolerabel sein – dort, wo Menschen, ihre Daten, ihre Rechte oder ihr Wohlergehen auf dem Spiel stehen, ist eine solche Haltung ethisch fragwürdig.

Abschließend lassen sich drei Leitgedanken formulieren:

- Verantwortung vor Geschwindigkeit: Entwickler sollten sich fragen, ob sie mit den möglichen Folgen ihrer Software leben können. Im Zweifel hat die Pflicht, Schaden abzuwenden, Vorrang vor dem schnellstmöglichen Rollout. Hans Jonas’ Appell an die Verantwortung für die Zukunft erinnert uns daran, dass Technikgestaltung immer ethische Konsequenzen hat[3].

- Prävention ist besser als Reaktion: Sicherheitslücken und ethische Konflikte im Nachhinein zu fixen, ist oft teuer – manchmal unmöglich. Vorsorgliche Maßnahmen (Security/Ethik by Design) schützen nicht nur die Nutzer, sondern am Ende auch die Innovatoren selber, indem Vertrauen gewahrt bleibt[4][4].

- Innovation mit Wertekompass: Fortschritt lässt sich nachhaltig nur erzielen, wenn er auf einem Fundament von Verantwortung ruht. “Move Fast” bleibt wichtig – niemand will blinden Stillstand – aber das “Break Things” muss eingebremst werden durch ein “Care for Things”. Eine Kultur, die Fehler als Lernchance sieht, ist positiv; doch eine Kultur, die Rücksichtslosigkeit in Kauf nimmt, ist gefährlich.

In einer Welt voller Software stehen Entwickler mehr denn je als Verantwortungsträger in der Pflicht. Die philosophische Frage nach der Verantwortbarkeit von Innovation lässt sich beantworten mit: Innovation ist verantwortbar, wenn sie reflektiert, achtsam und mit Blick auf ihre Folgen betrieben wird. Security by Design und Ethik by Design sind Wege, dieser Verantwortung gerecht zu werden – damit wir Neues schaffen, ohne die Welt zu zerbrechen. [2][3]

References

[1] Vorsorgeprinzip – pflanzen-forschung-ethik.de

[2] Balancing Security and Velocity in Modern Software Development

[3] The Mirai botnet explained: How IoT devices almost brought down the … [4] IoT Ethics: Navigating Privacy, Security & Responsibility