In der Erkenntnistheorie (Epistemologie) fragt man: Was ist Wissen? Was können wir mit Sicherheit erkennen? Diese klassischen Fragen stellen sich auch in der IT-Sicherheit: Woran merken wir, dass wir gehackt wurden? Können wir uns unserer Cyber-Sicherheit je ganz gewiss sein? In diesem Artikel verbinden wir epistemologische Konzepte – Wissen, Unsicherheit, Evidenz – mit der Praxis der Cybersecurity. Wir diskutieren das Problem der “unknown unknowns” (unbekannte Unbekannte) – also Sicherheitslücken oder Angreifer, von denen wir nicht einmal wissen, dass wir sie nicht kennen – und wie Sicherheitsexperten trotz solcher Ungewissheiten zu brauchbarem Wissen gelangen. Am Ende zeigt sich: Absolute Gewissheit ist selten, doch mithilfe systematischer epistemischer Methoden (z.B. Bayes’sche Wahrscheinlichkeitsanalysen) kann man informierte, rationale Sicherheitsentscheidungen treffen.

Wissen, Gewissheit und Evidenz: Grundbegriffe der Epistemologie

Bevor wir in die digitale Welt eintauchen, klären wir die erkenntnistheoretischen Grundlagen:

- Was ist Wissen? Traditionell wird Wissen in der Philosophie als „wahre, gerechtfertigte Überzeugung“ definiert[1]. Das heißt, man weiß etwas, wenn man eine wahre Aussage glaubt und dafür eine gute Begründung hat. Beispiel: Ich weiß, dass Feuer heiß ist, weil es wahr ist und ich es durch Erfahrung und wissenschaftliche Erklärung begründen kann. Doch diese klassische Definition wurde hinterfragt (siehe Gettier-Problematik) – aber der Kern bleibt: Wissen erfordert Wahrheitsnähe und stichhaltige Evidenz.

- Gewissheit vs. Unsicherheit: Philosophen wie Descartes strebten nach absoluter Gewissheit, wollten unbezweifelbares Wissen finden. In der Praxis müssen wir jedoch meist mit Unsicherheit leben. Wir haben oft nur Wahrscheinlichkeiten und Indizien statt 100%ige Beweise. Erkenntnistheoretisch spricht man von Fallibilismus: Wir akzeptieren, dass unser Wissen fehlbar ist, aber handeln trotzdem vernünftig danach, solange es ausreichend begründet ist. Es gilt: Keine Evidenz ist vollkommen, kein Wissen ohne Restzweifel. Gerade in der Wissenschaft und Technik arbeiten wir mit Modellen und Statistiken – also mit Grad an Sicherheit, nicht absoluter Wahrheit.

- Evidenz und Begründung: Evidenz meint Anhaltspunkte, Beobachtungen oder Daten, die eine Überzeugung stützen. Je stärker die Evidenz, desto gerechtfertigter das Für-wahr-Halten. Epistemologisch bewertet man: Wie gut rechtfertigt diese Evidenz meinen Glauben an X? Im Alltag ist das zum Beispiel Zeugenaussage + Fingerabdruck als Evidenz dafür, dass jemand am Tatort war – zusammen überzeugender als allein. In der IT-Security übersetzt sich das später in Logs, Alarme, Anomalien als Hinweise auf einen Angriff. Wichtig: Das Fehlen von Evidenz ist nicht gleich Evidenz für Fehlen – nur weil ich nichts Verdächtiges sehe, ist nicht bewiesen, dass nichts passiert ist[2]. Dieses Prinzip ist zentral, um Selbstgefälligkeit zu vermeiden.

Erkennen eines Cyber-Angriffs: Wissen in der IT-Sicherheit

Angenommen, Sie sind IT-Sicherheitsverantwortlicher: Wie wissen Sie, dass Ihr System gehackt wurde? Direkt sehen kann man einen Cyberangriff selten – Erkenntnis entsteht hier indirekt, aus Spuren und Zeichen:

Indikatoren und Evidenz in der IT: In modernen Systemen sammeln wir Unmengen an Daten (Logs von Servern, Netzwerkverkehr, User-Aktivitäten). Daraus versuchen Sicherheitstools und Analysten, Evidenz für Angriffe zu gewinnen:

- Signaturbasierte Hinweise: Virenscanner erkennen bekannte Schadsoftware anhand digitaler Signaturen. Wenn z.B. eine Datei das Muster eines bekannten Virus enthält, ist das evidenter Hinweis – ein bekanntes Anzeichen für Kompromittierung.

- Verhaltensbasierte Anomalien: Was aber, wenn der Angreifer zuvor unbekannte Malware nutzt? Hier schaut man auf Abweichungen vom Normalverhalten: ungewöhnlich großer Datenabfluss um 3 Uhr morgens, ein Nutzerkonto loggt sich plötzlich von einem fremden Land ein, ein Server stürzt ohne Grund mehrfach ab. Solche Anomalien sind Indizien – keine Beweise, aber Hinweise, dass etwas nicht stimmt.

Die epistemische Herausforderung: Kein einzelnes Signal beweist einen Hack zweifelsfrei. Es könnte immer eine harmlose Erklärung geben (der Datenabfluss war ein Backup, der Login aus dem Ausland ein Mitarbeiter im Urlaub). Wie sammeln wir also genügend Gewissheit? Sicherheitsanalysten arbeiten hier ähnlich wie Kriminalermittler: aus vielen Hinweisen ein Bild zusammensetzen. Wenn mehrere unabhängige Anzeichen zusammenkommen – etwa verdächtige Logins und ungewöhnlicher Datenverkehr und ein Alarm des Virenscanners – steigt unsere Zuversicht, dass ein Angriff im Gang ist. In epistemologischer Sprache: die Konvergenz von Evidenzen erhöht den Grad der Rechtfertigung für die Annahme „Wir wurden gehackt“.

False Positives und False Negatives: Immer drohen zwei Irrtümer:

- False Positive: Wir halten fälschlich etwas für einen Angriff (Irrtum erster Art). Zuviel misstrauen kann zu Fehlalarmen führen – wie ein Rauchmelder, der bei Dampf anschlägt.

- False Negative: Wir übersehen einen echten Angriff (Irrtum zweiter Art) – gefährlicher, denn wir wissen nicht, dass wir nichts wissen. Ein gut getarnter Hack kann lange unbemerkt bleiben.

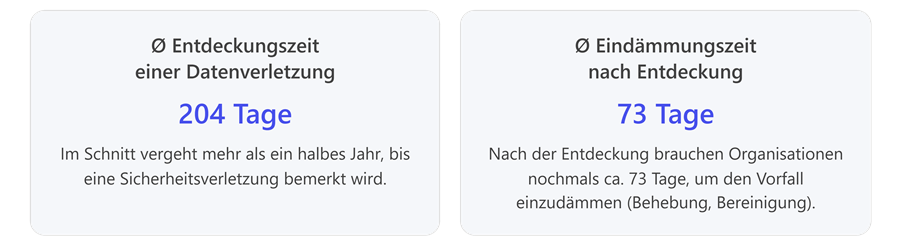

Leider zeigt die Praxis, dass False Negatives häufig vorkommen: Laut IBM dauert es durchschnittlich 204 Tage, bis eine Datenverletzung überhaupt entdeckt wird[3]. Über ein halbes Jahr könnten Angreifer also unentdeckt im System bleiben – ein erschreckendes Beispiel für unser Unwissen. In dieser Zeit lebt das Unternehmen in falscher Sicherheit, ein Unknown Unknown: Man hat keine Ahnung, bereits gehackt zu sein.

Diese Zahlen illustrieren das Erkenntnisproblem: Wir sind oft erst im Nachhinein schlauer. Wenn ein Angreifer so lange unerkannt bleiben kann, heißt das auch: während der Attacke wussten wir nichts davon. Es gab evtl. schwache Signale, aber nicht genug, um als Beweis durchzudringen. Erst später – vielleicht durch einen externen Hinweis oder beim Auftauchen gestohlener Daten im Internet – erlangen wir Wissen über den Angriff.

Fazit Zwischenschritt: In der IT-Sicherheit ist Wissen stets vorläufig und empirisch. Es basiert auf Indizien und Wahrscheinlichkeiten, nicht auf direkter Gewissheit. Zu wissen, dass man gehackt wurde, heißt meist: ausreichend starke Evidenz angehäuft zu haben, um vernünftigerweise von einem Angriff auszugehen. Doch wie gehen wir mit dem um, was wir nicht wissen können?

“Unknown Unknowns”: Unbekannte Unbekannte und die Grenzen des Wissens

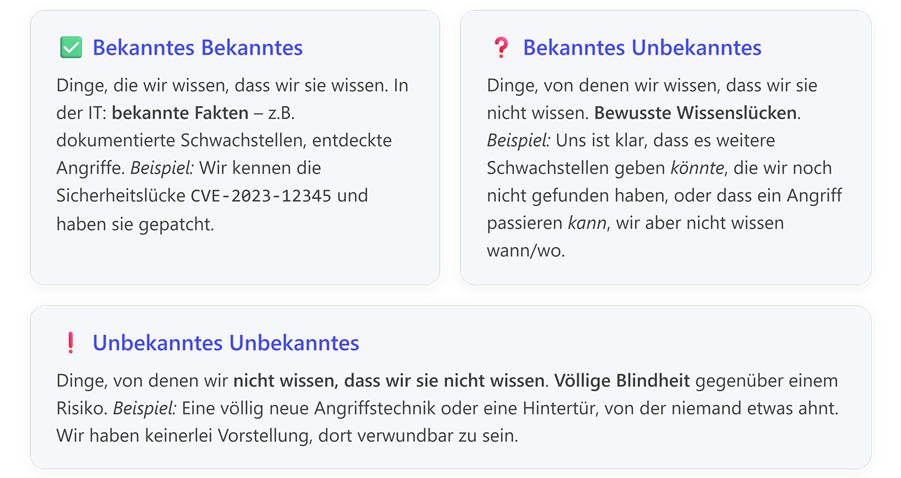

Der ehemalige US-Verteidigungsminister Donald Rumsfeld prägte 2002 die berühmte Unterscheidung zwischen bekannten und unbekannten Unbekannten[2]. Übertragen auf die Cyber-Welt:

Rumsfelds Punkt war: Die gefährlichsten Risiken sind die, an die wir gar nicht denken, eben die unbekannten Unbekannten[2]. In Cybersecurity sind das z.B. Zero-Day-Exploits (Schwachstellen, die noch völlig unbekannt sind und gegen die es folglich auch keinen Schutz gibt) oder neuartige Angriffsvektoren. Ein aktuelles Beispiel war der SolarWinds-Hack 2020: Angreifer kompromittierten eine weit verbreitete Software auf eine Weise, die zuvor nie gesehen wurde – für die betroffenen Firmen war das ein unbekanntes Unbekanntes; sie hatten keine Möglichkeit, diese Gefahr vorherzusehen oder direkt zu entdecken.

Wie geht man mit solchem fundamentalem Nicht-Wissen um? Hier kommt wieder epistemologische Demut und Strategie ins Spiel:

- Bewusstmachen von Unkenntnis: Der erste Schritt ist anzuerkennen, dass es immer unbekannte Risiken geben wird. Sicherheitsexperten plädieren oft dafür, „Assume Breach“ zu denken – also anzunehmen, es könnte längst ein Eindringling im Netzwerk sein, auch ohne Anzeichen. Dieses Mindset hilft, nicht blind zu vertrauen, sondern wachsam zu bleiben.

- Indirekte Anzeichen suchen: Auch wenn man das Unbekannte nicht direkt kennt, kann man indirekt danach fahnden. Beispiel: Wenn ich nicht weiß, welche Zero-Day-Lücke der Gegner nutzen könnte, beobachte ich auffälliges Verhalten in meinen Systemen allgemein (Anomalieerkennung). Ich kenne zwar die Ursache nicht, aber sehe die Wirkung. So kann man unbekannten Angriffsmethoden auf die Schliche kommen, indem man ihre Konsequenzen bemerkt, selbst ohne sie namentlich zu kennen.

- Resilienz statt Allwissen: Da völlige Kenntnis utopisch ist, setzt man auf Resilienz: Systeme so bauen, dass selbst Unbekanntes nicht gleich katastrophal wirkt. Z.B. Netzwerke segmentieren (falls ein unbekannter Wurm eindringt, bleibt er lokal begrenzt) oder Backups vorhalten (falls eine neue Ransomware zuschlägt, können Daten wiederhergestellt werden). Man plant für das Unvorhersehbare im Voraus mit ein.

In der Sprache Rumsfelds könnte man hinzufügen: Man muss das Unbekannte Unbekannte zumindest als abstrakte Möglichkeit mitdenken. Absolute Sicherheit in dem Sinne, alles zu wissen, ist unmöglich. Daher verschiebt sich der Fokus auf Umgang mit Ungewissheit.

Übrigens passt hier noch ein Zitat aus derselben Pressekonferenz Rumsfelds, das den epistemologischen Kern trifft: „Das Fehlen von Beweisen ist kein Beweis für das Fehlen…“[2]. In Cyberterms: Nur weil wir keinen Alarm haben, heißt das nicht, dass nichts passiert. Dieses Motto sollten Sicherheitsteams beherzigen, um nicht Opfer ihrer Unwissenheit zu werden.

“Workable Knowledge”: Handlungsfähiges Wissen trotz Unsicherheit

Wie können Sicherheitsexperten nun trotz all dieser Unsicherheiten praktisch handeln? Die Antwort liegt in pragmatischen Ansätzen: Man arbeitet mit Wahrscheinlichkeiten, Schätzungen und regelmäßiger Revision des Wissensstands, um hinreichend sichere Grundlagen für Entscheidungen zu haben – „workable knowledge“ eben.

Von absolutem Wissen zu risikobasierten Annahmen: In der Praxis sagt ein CISO (Chief Information Security Officer) selten: “Ich weiß 100%ig, dass wir sicher sind.” Stattdessen arbeitet man mit Risikoeinschätzungen: “Nach aktuellem Kenntnisstand schätzen wir das Risiko eines Angriff X als gering ein, aber bei Y erhöht.” Dieses Wissen ist konditional und graduell: Es kann morgen neue Erkenntnisse geben (z.B. bekannt werden, dass eine Lieferkette kompromittiert ist – plötzlich steigt Risiko X). Sicherheitsteams müssen also ihr Wissen laufend anpassen – eine Art iteratives Näherungsverfahren an die Realität.

Bayesianische Sicht: Wissen in Wahrscheinlichkeiten ausdrücken: Ein moderner epistemischer Ansatz ist die Verwendung Bayes’scher Wahrscheinlichkeiten. Die Bayes-Statistik interpretiert Wahrscheinlichkeit als subjektives Maß an Glauben, das mit neuen Evidenzen aktualisiert wird[4]. Für die IT-Security heißt das: Man weist den Hypothesen („Wir sind gehackt“ vs. „kein Hack“) Wahrscheinlichkeiten zu und aktualisiert sie, sobald neue Hinweise auftauchen.

Beispiel: Angenommen, initial halten wir einen Angriff für unwahrscheinlich (sagen wir 5% Chance). Plötzlich entdeckt das Monitoring ungewöhnlichen Netzwerk-Traffic, der mit 80% Wahrscheinlichkeit auf Malware hindeutet. Mit Bayes’schem Theorem können wir nun die Posterior-Wahrscheinlichkeit berechnen: Wie wahrscheinlich ist ein Angriff gegeben dieses neue Indiz? Diese könnte nun z.B. auf 50% springen – unser Glauben an einen laufenden Angriff hat sich deutlich erhöht aufgrund der Evidenz[4]. Kommen weitere Anzeichen hinzu (Antivirenscan findet eine verdächtige Datei, ein Server stürzt ab), erhöhen wir weiter. Ab einem Schwellenwert – etwa >90% – ziehen wir die Notbremse (Incident Response Team alarmieren, Systeme isolieren). So ein Ansatz macht die Entscheidung nachvollziehbar und rational: Wir reagieren nicht bei 5% (das wäre zu viele Fehlalarme), aber wir warten auch nicht auf 100% (das käme womöglich zu spät), sondern haben einen methodischen Mittelweg.

In diesem fiktiven Ablauf sieht man: Wissen im Sinne von „Überzeugung mit hoher** Wahrscheinlichkeit“ wächst schrittweise. Das Konzept „workable knowledge“ bedeutet, handlungsfähiges Wissen zu erlangen, ohne auf hundertprozentige Beweise zu warten – denn im dynamischen Cyber-Umfeld wäre das oft zu spät. Stattdessen arbeiten Experten mit epistemischen Standards: Sie definieren, ab wann eine Hypothese als ausreichend gesichert gilt, um Entscheidungen abzuleiten. Dieser Schwellenwert kann von der Risikotoleranz abhängen. In einem Atomkraftwerk würde man bei schon 10% Hinweis auf einen digitalen Vorfall reagieren, in einer weniger kritischen Umgebung vielleicht erst bei 70%. Wichtig ist: Man trifft die Entscheidung bewusst auf Basis der besten verfügbaren (wenn auch unsicheren) Information.

Wissen teilen und verbessern: Ein weiterer Aspekt: Sicherheitsteams bauen ihr Wissensnetzwerk aus. Durch Threat Intelligence tauschen Firmen Informationen über neue Bedrohungen aus – so werden aus vormals unbekannten Unbekannten mit Glück bekannte Unbekannte oder sogar bekannte Bekannte, wenn man Indikatoren eines neuen Angriffstyps erfährt. Diese kollektive Wissensbildung ist zentral, um epistemische Lücken zu verkleinern. Jeder neue entdeckte Angriff erweitert das allgemeine Wissen und reduziert die Terra Incognita der Cyber-Bedrohungen ein Stück.

Epistemische Methoden in der Security-Praxis: Rational handeln trotz Zweifel

Abschließend fassen wir zusammen, wie epistemologische Prinzipien ganz praktisch in der Cybersecurity eingesetzt werden, um mit Unsicherheit umzugehen:

- Risikodenken statt Absolutheitsanspruch: Statt „sicher/unsicher“ dichotom zu denken, wird Wissen in Wahrscheinlichkeiten und Risiken ausgedrückt. Das erlaubt es, graduelle Entscheidungen zu treffen (z.B. höhere Wachsamkeit bei mittlerem Risiko, Vollalarm bei hohem Risiko)[5]. Diese Mentalität ist implizit epistemologisch – man akzeptiert Ungewissheit und managt sie aktiv.

- Bayes’sche Updates und statistische Modelle: Moderne Sicherheitssysteme nutzen Machine Learning und Bayes’sche Netze, um aus vielen schwachen Signalen ein Gesamtbild zu berechnen[4]. Zum Beispiel in SIEM-Systemen (Security Information and Event Management) werden Ereignisse bewertet und korreliert; im Hintergrund laufen gewichtete Wahrscheinlichkeitsmodelle, die den Analysten unterstützen, Prioritäten zu setzen (welche Warnung ist ernst, welche eher falsch positiv?). So fließt epistemische Methodik direkt in Tools ein.

- Known Knowns vs. Unknowns aktiv managen: Viele Organisationen führen regelmäßige Penetrationstests und Red-Team-Übungen durch, um bekannte Unbekannte aufzudecken – man versucht also bewusst, blinde Flecken zu finden: Tester agieren wie Hacker und schauen, ob sie Lücken entdecken, von denen das Unternehmen nichts wusste. Auch Bug-Bounty-Programme (Hacker werden belohnt, wenn sie unbekannte Schwachstellen melden) tragen dazu bei, die Zone des Nicht-Wissens zu verkleinern. Das ist angewandte Epistemologie: Erkenne, was du nicht weißt, dann weißt du zumindest, wo du suchen musst.

- Debiasing und kritisches Denken: Menschen neigen zu kognitiven Verzerrungen, die Erkenntnis schmälern können – z.B. Bestätigungsfehler (man schenkt Informationen, die die Annahme „wir sind sicher“ stützen, mehr Beachtung als widersprechenden Hinweisen). Ein bewusster, epistemisch geschulter Sicherheitsanalyst wird versuchen, solche Fallen zu vermeiden: z.B. gezielt die Hypothese „Wir könnten gehackt sein“ falsifizieren wollen, anstatt voreilig Entwarnung zu geben. Das erinnert an die wissenschaftliche Methode (Hypothesen testen, auch mal vom Gegenteil ausgehen).

- Keine Sicherheit durch Nichtwissen: Ein fatales Muster ist manchmal: „Wir haben nichts gesehen, also ist alles gut.“ – Wir haben schon gelernt, dass Nichtwissen an sich kein Schutz ist. Ethische Hacker sagen: „Security through obscurity is no security“ – also Sicherheit durch Verborgenheit (hoffen, dass der Gegner es nicht kennt) ist trügerisch. Besser ist, aktiv Wissen zu sammeln: Logfiles auswerten, nach Indicators of Compromise suchen, im Zweifel externe Forensik hinzuziehen. Kurz: Lieber der unbequemen Wahrheit ins Auge sehen, als sich epistemisch selbst zu betrügen.

Schlussfazit: Vollständige Gewissheit in der Cybersecurity ist so rar wie im restlichen Leben. Wir bewegen uns in einem Spannungsfeld von bekanntem Wissen, vermuteten Lücken und unvorhersehbaren unbekannten Faktoren. Doch genau wie die Philosophie Werkzeuge entwickelte, um trotz Unsicherheit zu Erkenntnis zu gelangen, nutzt die IT-Sicherheit heute Wahrscheinlichkeitsmodelle, kontinuierliches Lernen und geteilte Information, um handlungsfähiges Wissen zu schaffen.

Durch den Einsatz von epistemischen Standards – seien es formale wie Bayes’sche Risikoanalysen oder informelle wie ein kritisches, hinterfragendes Mindset – können Sicherheitsexperten rational agieren, ohne in Paranoia oder Sorglosigkeit zu verfallen. Sie wissen, dass sie nicht alles wissen können, aber sie nutzen bestmöglich das, was sie wissen, und verbessern ihren Wissensstand kontinuierlich.

Am Ende treffen sich hier Theorie und Praxis: Erkenntnistheorie lehrt uns bescheidene, aber robuste Wissensansprüche – und genau das brauchen wir, um der dynamischen, unsicheren Welt der Cyber-Bedrohungen erfolgreich zu begegnen. Mit anderen Worten: Wir können nie alle „Unknown Unknowns“ eliminieren, doch wir können uns so wappnen, dass wir trotz unvermeidbarer Unsicherheit vernünftig und effektiv für unsere Sicherheit sorgen.[2][5]

References

[1] Wissen als wahre, gerechtfertigte Überzeugung (eine Fußnote zu Platon)

[2] Donald Rumsfeld – Wikiquote

[3] 101 der neuesten Datenpannenstatistiken für 2024 – Secureframe